Sind wir so vom Glanz der neuesten technologischen Errungenschaften geblendet, dass wir KI blind vertrauen? Jay Krihak, Executive Director bei CROSSMEDIA New York, fordert dringend kontrollierende Instanzen, wenn wir nicht Opfer der Folgen von unregulierter künstlicher Intelligenz werden wollen.

Hier gibt’s den Artikel als Audiospur – vorgelesen von einer KI:

Bevor es Computer gab, war jeder industrielle Prozess visuell zu erfassen. Wir konnten Ruder, Segel, Schrauben und Zahnräder sehen. Es war leicht zu erkennen, wie die einzelnen Teile einer Maschine diese zum Laufen brachten. Transparenz zu schaffen war so einfach, wie die Motorhaube eines Autos zu öffnen, um einen Blick auf den Motor zu werfen, oder auf eine Werbetafel zu schauen. Und wie die Dinge funktionierten, wurde von den Regulierungsbehörden dokumentiert. Sogar die streng geheime Formel von Coca-Cola – die vor der Konkurrenz unter Verschluss gehalten wurde – musste von der FDA (U.S. Food & Drug Administration) genehmigt werden, um zu garantieren, dass sie für den Menschen sicher war. Im fünften Industriezeitalter der künstlichen Intelligenz aber wird Technologie nun eher als Magie denn als Maschine betrachtet. In der heutigen digitalen Welt von Websites, Apps und Games gibt es keine Prüfung von Algorithmen durch die FDA oder vorgeschriebene Tests zur Überwachung ihrer gesellschaftlichen Auswirkungen.

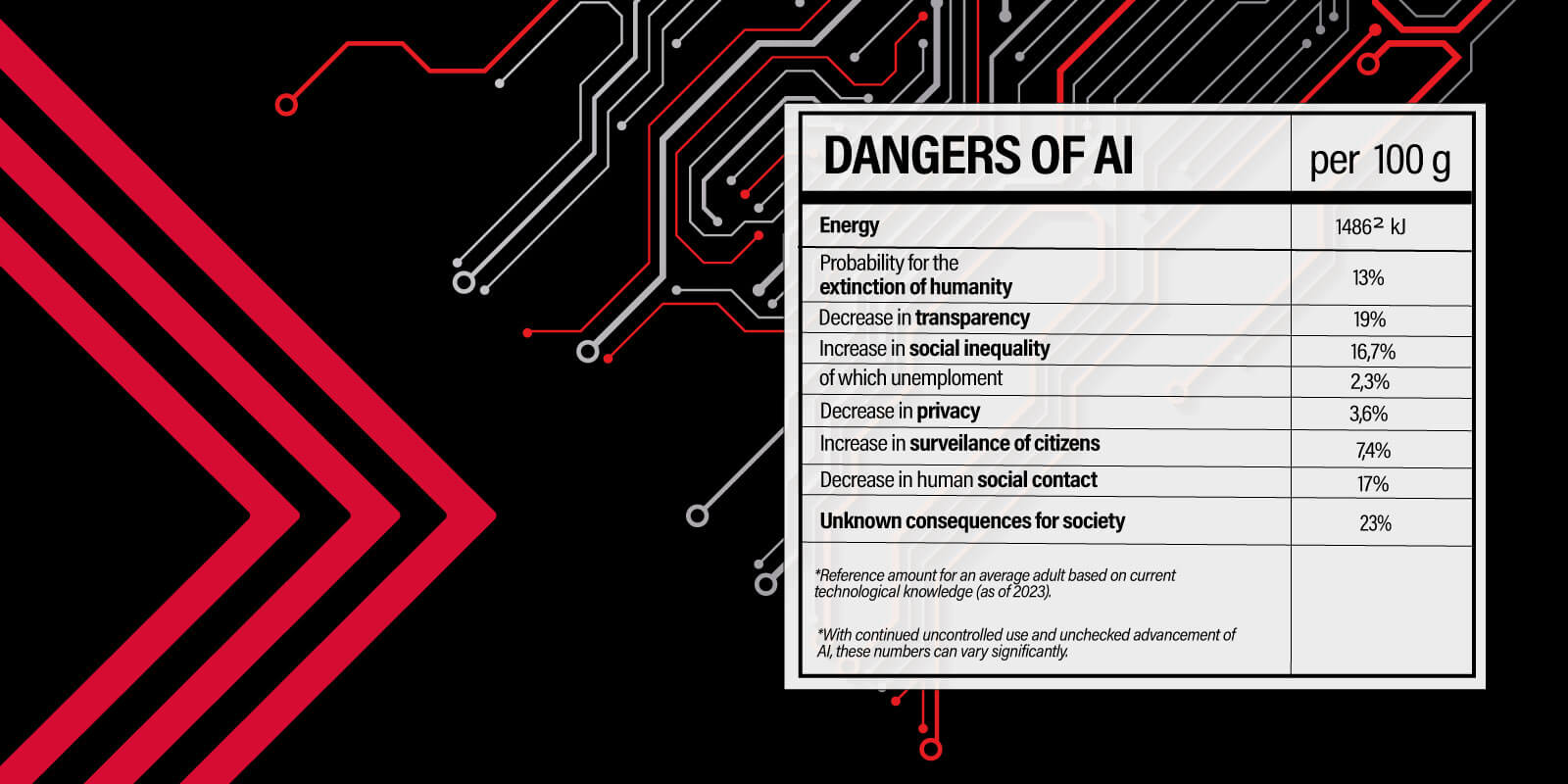

Schloss und Schlüssel sind oft im Besitz einer einzigen Person, und die geheime Algorithmus-Formel wird in einer Black Box aufbewahrt, die niemand zu Gesicht bekommt, der nicht Mark, Sundar, Jeff oder Elon heißt. Eigentlich neigen Menschen dazu, das zu fürchten, was sie nicht verstehen. In letzter Zeit ist jedoch das Gegenteil eingetreten: Wir bringen der Technologie und jenen Menschen, die sie entwickeln, zu viel Vertrauen entgegen. Man denke nur an den kometenhaften Aufstieg von ChatGPT und die Blüten, die diese Technologie bereits in der Branche treibt. Um Jeff Goldblums berühmten Satz aus Jurassic Park zu paraphrasieren: Es scheint, dass wir Technologien erschaffen, weil wir es können – ohne darüber nachzudenken, ob wir es sollten. Diese Meinung wurde kürzlich auch von OpenAI-CEO Sam Altman und Geoffrey Hinton, dem „Godfather of AI“, geäußert, der bei Google kündigte, um vor den existenziellen Gefahren von KI zu warnen.

Soziale Medien haben uns etwas gelehrt

Mit dem laufenden Echtzeit-Experiment, das sich Social Media nennt, haben wir den Beweis erbracht, dass unkontrollierte Technologie erhebliche persönliche und gesellschaftliche Folgen haben kann. Die jüngste Vergangenheit hat gezeigt, dass Black-Box-Algorithmen zur Optimierung von Business-Zahlen schwerwiegende, schädliche Folgen haben können, die oft nicht vorhersehbar sind.

- Mentale Gesundheit: Der Zugang zu Facebook an Hochschulen hat zu einem Anstieg schwerer Depressionen um 7 % und zu einem Anstieg von Angststörungen um 20 % geführt.*

- Blick auf das eigene Selbst: Untersuchungen auf Instagram haben gezeigt, dass die Nutzung der Plattform bei jungen Mädchen und Frauen zu einem höheren Risiko von Essstörungen, Depressionen, geringerem Selbstwertgefühl, Stress bei der Auseinandersetzung mit dem eigenen Aussehen und Unzufriedenheit mit dem eigenen Körper führt und gleichzeitig den Wunsch nach Schlankheit sowie das Interesse an kosmetischen Eingriffen verstärkt.**

- Verbreitung von Fehlinformationen: Die verstärkte Verbreitung von Fehlinformationen aus internationalen und nationalen Quellen bedroht alles, von der nationalen Gesundheit (Beispiel: Impfstoffe) bis hin zu Präsidentschaftswahlen.

Der Gott-Komplex von CEOs und Unternehmen, die predigen, dass ihr Weg der beste, gerechteste und einzige Weg für KI ist, hat uns Algorithmen beschert, die im Namen von mehr Engagement auf ihren Plattformen Hass und Fehlinformationen verbreiten. Was passiert, wenn Menschen einer KI mit Superkräften ein paar Ziele vorgeben, die sie unter Anleitung erreichen soll, und keinerlei Leitplanken oder Kontrollen einbauen, um sie im Zaum zu halten?

Unkontrollierte KI ist keine Option

Wenn derart viel auf dem Spiel steht, kann die Antwort nicht lediglich eine weitere zahnlose Selbstregulierungsrichtlinie wie die für AdChoices sein. Wir müssen jetzt sofort mit allen uns zur Verfügung stehenden Mitteln handeln! An allererster Stelle ist es wichtig, ein gewisses Maß an Transparenz für die Kontrolle von KI gesetzlich zu verankern. Wir brauchen Gesetze für die Rechenschaftspflicht von Menschen und Unternehmen, insbesondere dort, wo es um Social-Media-Plattformen geht. In unserer Branche ist in den USA die Network Advertising Initiative (NAI) ein Beispiel für ein Branchengremium, das die gesetzeskonforme Erhebung und Nutzung personenbezogener und sensibler Daten sicherstellen soll. In Bezug auf KI brauchen wir eine fortschrittlichere Aufsichtsbehörde, die deren Einsatz in der Branche prüft und regelt. Und Unternehmen, die KI einsetzen, müssen ihr gegenüber verpflichtet sein.

Des Weiteren ist es sinnvoll, das Vordringen von künstlicher Intelligenz in bestimmte Bereiche so lange zu unterbinden, bis KI vertrauenswürdig ist. Das Gesundheitssystem ist das deutlichste Beispiel für einen Bereich, in dem Fehlinformationen egal ob auf die physische oder psychische Gesundheit bezogen tödliche Folgen haben können. Die Auswirkungen von KI im Gesundheitswesen und anderswo müssen sorgfältig geprüft werden, bevor wir sie der Öffentlichkeit zugänglich machen.

Bereicherung statt Alleingang

Es braucht dringend einen Richtungsweiser für KI in der Werbebranche – einen, der mehr als nur die Werbung und ihre Akteure schützt. Hier ist ein Vorschlag: KI darf nur eingesetzt werden, um Reibungsverluste in Arbeitsabläufen zu beseitigen und um menschliche Kreativität zu erweitern und zu stärken. Aber selbst dann dürfen wir KI nur mit angemessener Zustimmung, Anerkennung und Entschädigung der Eigentümer des geistigen Eigentums, welches die Modelle trainiert, einsetzen. Und wir dürfen die Ergebnisse nicht als unumstößliche Wahrheit ansehen, ohne dass der Mensch in erheblichem Maße eingreift, um Vertrauen und Transparenz zu schaffen. Wenn wir uns auf diese Grundsätze einigen können, lassen sich die Anreize in unserer Branche vielleicht zur Abwechslung einmal in Einklang bringen.

Dieser Artikel wurde zuerst auf AdExchanger eröffentlicht.

*https://mitsloan.mit.edu/ideas-made-to-matter/study-social-media-use-linked-to-decline-mental-health

**https://www.forbes.com/sites/kimelsesser/2021/10/05/heres-how-instagram-harms-young-women-according-to-research/?sh=5dc26f72255a

Was denkst du?